| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | ||

| 6 | 7 | 8 | 9 | 10 | 11 | 12 |

| 13 | 14 | 15 | 16 | 17 | 18 | 19 |

| 20 | 21 | 22 | 23 | 24 | 25 | 26 |

| 27 | 28 | 29 | 30 |

- Red Hat

- vlan

- Ansible

- freeradius

- 네이티브 vlan

- BPDU

- Packet Tracer

- centos

- 오블완

- STP

- pagp

- junos os

- LACP

- Network Design

- Cisco

- 프로그래머스

- pvst+

- 하프오픈

- rommon mode

- stream 9

- 방화벽

- gns3

- 네트워크 설계

- ansible playbook

- 네트워크

- ospf

- port aggregation protocol

- eigrp

- SQL

- 티스토리챌린지

- Today

- Total

Doctor Pepper

[네트워크 설계] L2/L3 네트워크 본문

1. L2/L3 네트워크

- L2 네트워크

2계층 네트워크는 동일 네트워크 내에서 호스트 간 통신이 2계층 프로토콜을 통해 직접 이루어지는 구조이다. 동일 네트워크에 속한 호스트 간에는 게이트웨이를 경유하지 않고 직접 통신할 수 있다.

2계층 네트워크는 하나의 브로드캐스트 도메인으로 구성되며, 루프(Loop) 구조가 발생할 경우 네트워크에 심각한 문제가 생길 수 있다. 이를 방지하기 위해 스패닝 트리 프로토콜(STP)을 사용하여 루프를 차단한다. 그러나 STP 사용 시 일부 링크가 블로킹되어 전체 대역폭을 효율적으로 활용하지 못하는 문제가 발생한다. 이를 해결하기 위해 MC-LAG와 같은 기술을 도입하여 루프를 제거하고 논블로킹(Non-Blocking) 구조를 구현할 수 있다.

- L3 네트워크

3계층 네트워크는 라우팅 프로토콜을 기반으로 호스트 간 통신이 이루어지는 구조이다. 라우팅을 통해 네트워크가 구성되므로 루프 문제는 발생하지 않으며, ECMP(Equal-Cost Multi-Path) 기술을 사용하여 전체 네트워크 대역폭을 효율적으로 활용할 수 있다.

L3 네트워크의 한계는 라우터를 통해 다른 네트워크 간 통신이 이루어지므로, 호스트가 동일한 네트워크에 속해 있지 않으면 브로드캐스트를 통한 직접 통신이 불가능하다. 이로 인해 2계층 통신이 필요한 환경에서는 3계층 설계를 바로 적용하기 어렵다.

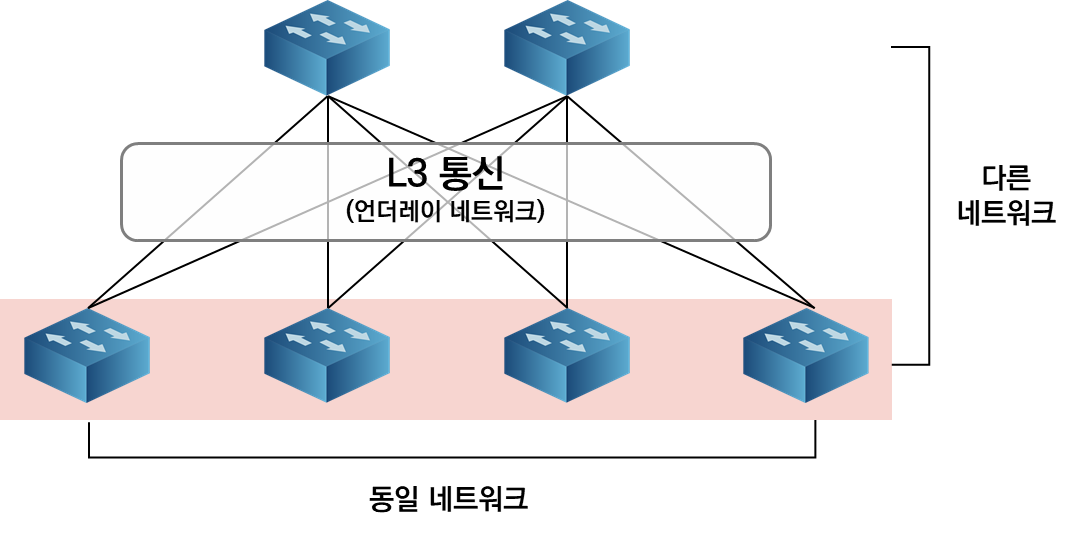

- 3계층 언더레이 기반의 오버레이 L2 네트워크

VxLAN과 같은 오버레이 네트워크 기술은 3계층 기반 통신을 활용하면서도 2계층 네트워크 확장이 가능하도록 설계할 수 있다. 이를 통해 하단 호스트 간 동일 네트워크를 유지하면서, 3계층의 장점인 루프 없는 구조와 대역폭 활용을 극대화할 수 있다.

이러한 오버레이 기술은 VxLAN, GRE와 같은 터널링 프로토콜을 기반으로 하며, 2계층과 3계층의 장점을 결합한 유연하고 확장 가능한 네트워크 구성을 제공한다.

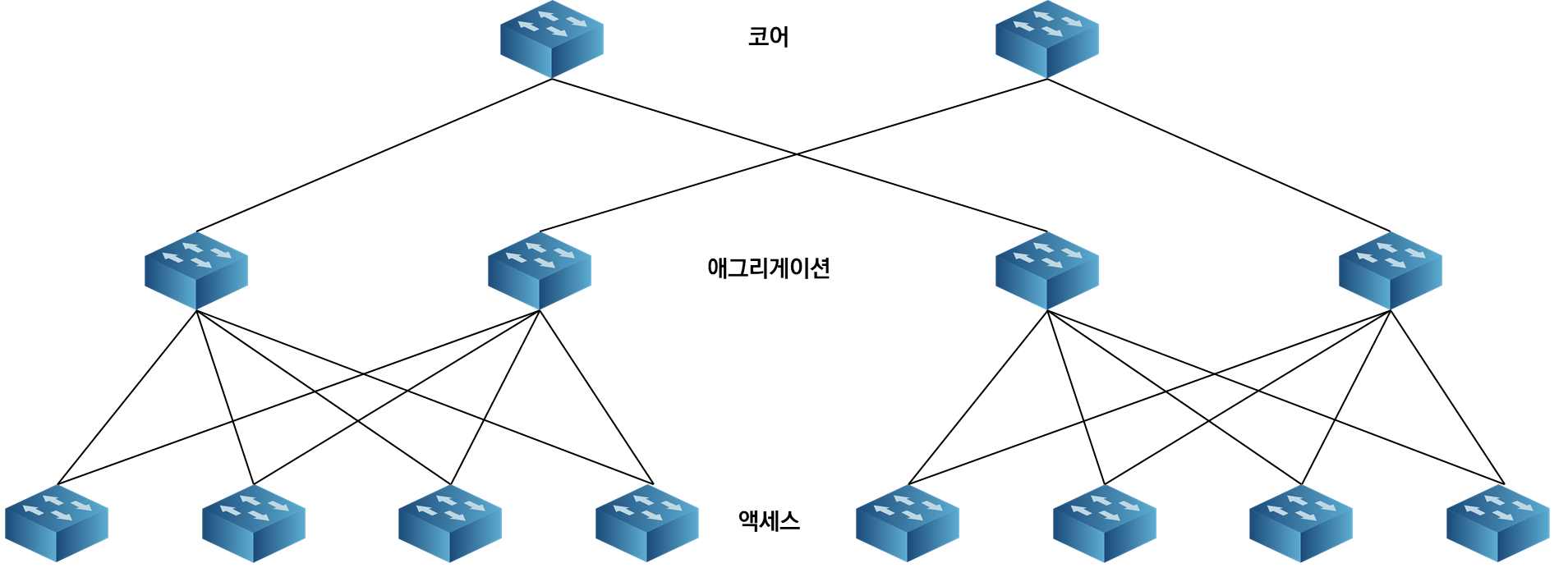

2. 3-Tier 아키텍처

3-Tier 아키텍처는 코어(Core), 애그리게이션(Aggregation), 액세스(Access)의 3계층으로 구성된 전통적인 네트워크 설계 기법으로, 데이터 센터와 캠퍼스 네트워크 설계에서 널리 사용되는 구조이다.

- 구조 및 역할

| 코어 계층 | 애그리게이션 스위치를 집선하고 전체 네트워크의 고속 데이터 전송 및 통신을 담당함 |

| 애그리게이션 계층 | 액세스 스위치들을 집선하여 상위 계층인 코어 계층과 연결하는 중간 계층임 |

| 액세스 계층 | 호스트가 직접 연결되는 계층으로, 주로 액세스 스위치가 위치함 |

- 특징 및 고려 사항

- 상위 계층으로 갈수록 더 많은 장비를 집선하므로 높은 대역폭이 요구된다.

- 집선 구간에서 병목현상이 발생하지 않도록 업링크(Uplink) 연결 시 오버서브스크립션 비율(Oversubscription Ratio)을 적절히 산정해 설계해야 한다.

- 이 구조는 사용자의 요청이 서버에 전달되고 서버에서 사용자의 요청에 응답하는 North-South 트래픽이 주요 트래픽 유형인 환경에 적합하다.

3-Tier 아키텍처는 전통적인 데이터 센터 설계의 기반을 이루며, 오늘날에도 다양한 네트워크 환경에서 활용되고 있다.

3. 2-Tier 아키텍처

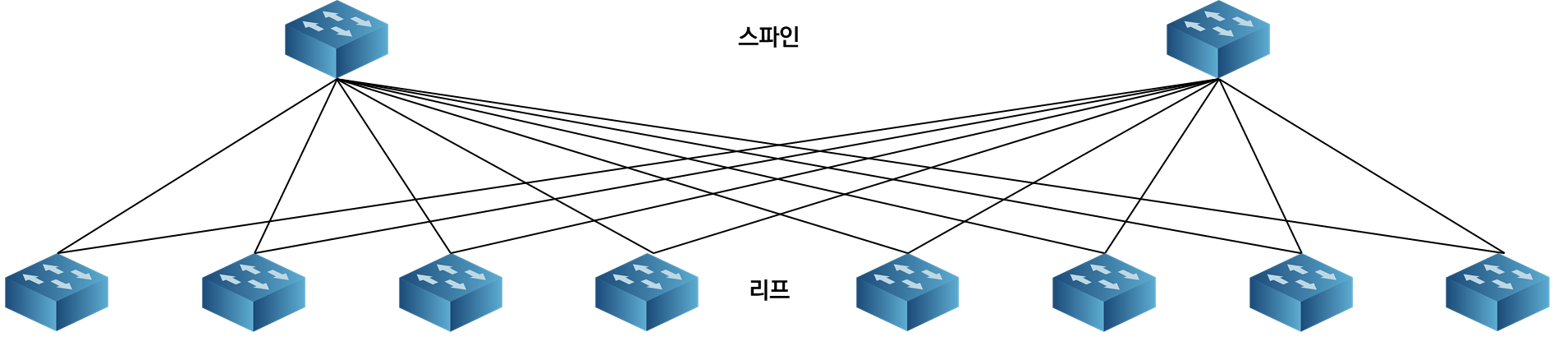

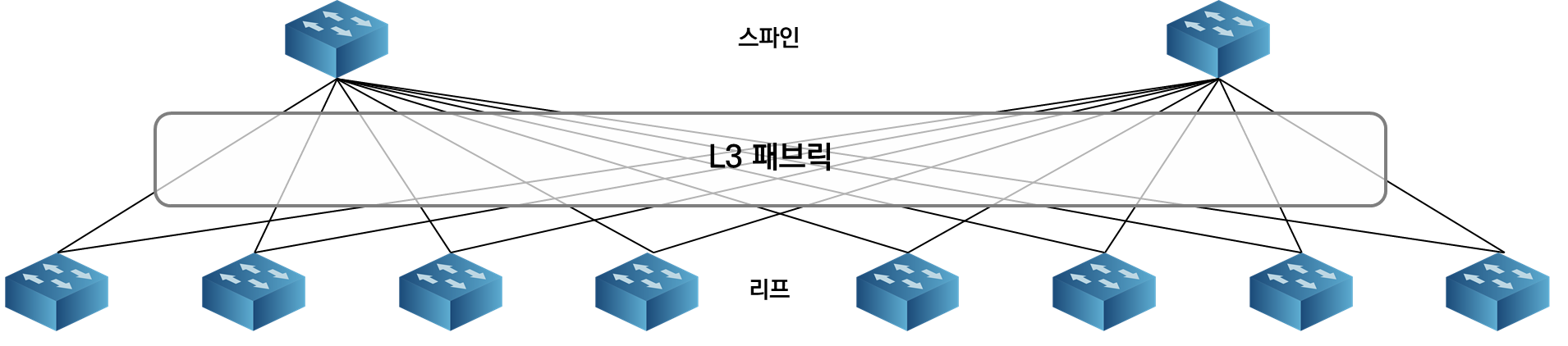

- 스파인-리프 구조

스파인-리프(Spine-Leaf) 아키텍처는 현대 데이터 센터 설계에서 널리 사용되는 2-Tier 네트워크 설계 기법으로, 대규모 서버 간 통신이 요구되는 환경에 최적화된 구조이다.

- 구조 및 특징 : 리프 스위치와 스파인 스위치 간 모든 링크를 활성화하여 트래픽을 전송함으로써 전통적인 2계층 네트워크에서 사용하는 스패닝 트리 프로토콜이 동작하지 않으며, 이를 통해 모든 호스트 간 트래픽 홉 수가 일정하게 유지되고 트래픽 흐름이 단순하고 효율적으로 처리된다.

| 리프 스위치 | 하단 호스트가 연결되는 스위치로, 모든 트래픽은 상단 스파인 스위치와 연결됨. |

| 스파인 스위치 | 리프 스위치 간 트래픽을 중계하며, 모든 리프 스위치와 전방위로 연결됨. |

- 변화의 배경 : 과거에는 North-South 트래픽(외부 사용자와 데이터 센터 간 통신)이 주요 트래픽이었지만, 현재는 데이터 센터 내 서버 간 대규모 분산 처리가 많아지면서 East-West 트래픽(서버 간 통신)이 급증했다.

- 기존의 3-Tier 아키텍처는 복잡한 계층 구조로 인해 트래픽 부하와 성능 지연 문제가 발생했다.

- 이를 해결하기 위해 홉 수를 줄이고 트래픽 흐름을 단순화한 스파인-리프 구조로 전환되고 있다.

| 장점 | 모든 호스트 간 동일한 홉 수로 네트워크 지연을 최소화함. 스파인-리프 간 모든 링크를 활용해 트래픽 부하를 균등하게 분산함. 2계층 또는 3계층 네트워크로 유연하게 구성할 수 있음. |

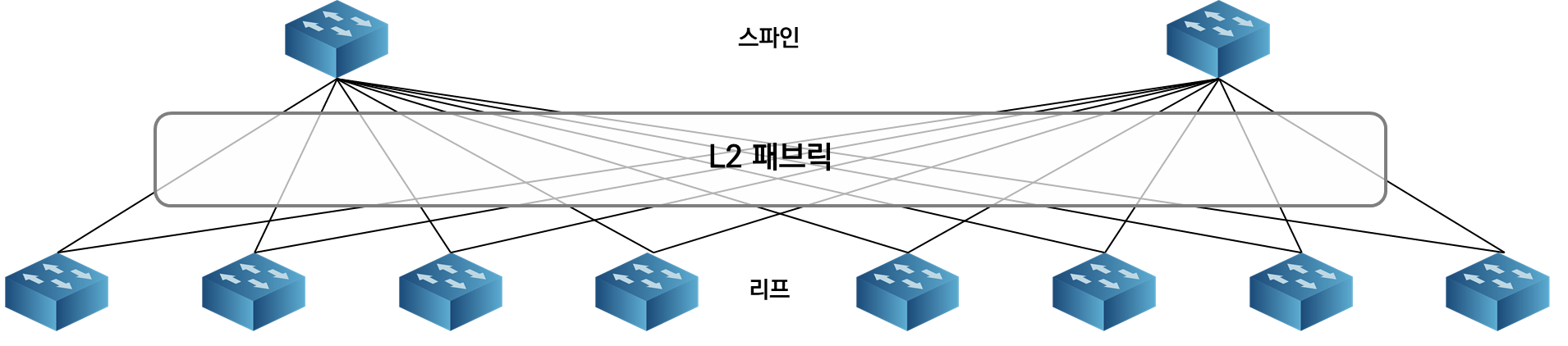

- L2 패브릭(Layer 2 Fabric)

L2 패브릭은 스파인-리프 구조에서 스파인과 리프 스위치 간의 연결을 2계층(Layer 2) 네트워크로 구성하는 방법이다. 전통적인 2계층 네트워크에서는 루프 문제를 피하기 위해 스패닝 트리(Spanning Tree Protocol)를 사용하지만, 이는 모든 링크를 활성화할 수 없다는 제한이 있다. 이 문제를 해결하기 위해 TRILL(Transparent Interconnection of Lots of Links)과 SPB(Shortest Path Bridging)와 같은 프로토콜이 도입되었다.

- TRILL과 SPB는 2계층 네트워크에서 모든 링크를 활용할 수 있도록 설계된 프로토콜로, 루프 문제를 해결하면서 효율적으로 트래픽을 전달한다.

- 이를 통해 스파인-리프 네트워크에서 네트워크의 효율성을 극대화하고, 대규모 데이터 센터 환경에서 발생할 수 있는 병목 현상을 줄일 수 있다.

Cisco Fabric Path나 Extreme Networks의 VCS Fabric과 같은 기술은 이와 같은 프로토콜을 기반으로 L2 패브릭을 구현한 벤더의 기술이다. 이들 기술은 고속의 2계층 네트워크를 구축할 수 있게 해주며, 트래픽 흐름을 최적화하고 대규모 데이터 센터 환경에 적합한 성능을 제공하다.

- L3 패브릭(Layer 3 Fabric)

L3 패브릭은 스파인-리프 구조에서 스파인과 리프 스위치 간의 연결을 3계층(Layer 3) 네트워크로 구성하는 방법이다. 이 방식에서는 각 스파인과 리프 간의 연결에 라우팅이 활성화되어 있으며, 일반적인 라우팅 프로토콜을 사용해 경로 정보를 교환한다. 라우팅 기반 구조이므로, 별도의 특별한 기술 없이도 루프 문제를 자연스럽게 해결하고, ECMP(Equal-Cost Multi-Path)를 통해 네트워크 내의 모든 링크를 효율적으로 활용할 수 있다.

- L3 패브릭은 루프를 제거하는 동시에 네트워크 트래픽의 효율적인 분배가 가능하며, 동적 라우팅을 통해 빠른 트래픽 경로 전환이 이루어진다.

하지만 L3 패브릭을 사용하면 하단의 호스트들이 서로 다른 네트워크를 가지게 되므로, 동일 네트워크 구성이 필요할 경우 추가적인 오버레이 기술이 필요하다. 이때 VxLAN과 같은 오버레이 네트워크 기술을 사용하면, L3 패브릭 상단의 구조에서 리프 스위치 하단의 2계층 네트워크를 확장하여 동일한 네트워크를 구현할 수 있다. 이러한 구성을 통해 가상화 서버의 라이브 마이그레이션과 같은 서비스에서 IP 이동을 보장하는 안정적인 네트워크 환경을 제공할 수 있다.

| ※ 참고 : East-West 트래픽 데이터 센터의 트래픽 패턴이 North-South 트래픽에서 East-West 트래픽으로 변한 데는 몇 가지 이유가 있다. |

|||

| 서버 가상화 | 빅데이터 대중화 | 애플리케이션 아키텍처와 개발 방법의 변화 |

|

| 설명 | 서버 호스트 하나에 다수의 가상 머신이 운영됨. 가상화 기술을 통해 여러 가상 머신이 운영될 수 있어, 서버들 간의 통신이 복잡해짐. 이로 인해 서비스 간 트래픽이 스파인을 통해 중계될 필요가 있음. 마이크로 서비스 아키텍처와 같은 분산형 구조에서는 빈번한 서비스 통신이 발생할 수 있음. | 오픈 소스 기반의 빅데이터 기술들이 대중화되며, 대규모 데이터를 저렴한 가격에 처리할 수 있게 됨. 하둡(Hadoop)과 같은 기술은 대량의 데이터 복제를 통해 서버 간 통신을 증가시킴. | 클라이언트와 서버뿐만 아니라 서버 간 통신이 빈번해짐. 마이크로 서비스 아키텍처에서는 다수의 단독 서비스로 분리된 서비스들 간의 내부 통신이 많아짐. VM, 컨테이너 같은 유연한 인프라 기반 기술이 사용됨. |

| 문제점 | 가상 머신 마이그레이션 과정에서 대량의 트래픽 발생 가능. 트래픽이 많아지면 네트워크 병목현상이 발생할 위험이 있음. | 하둡 등 빅데이터 기술의 복제 과정에서 대규모 트래픽 발생. 네트워크 지연과 성능 저하가 발생할 수 있음. | 빈번한 배포와 서비스 간 통신으로 인해 데이터 센터 내 트래픽이 증가할 수 있음. |

| 해결책 | 스파인-리프 구조를 통해 루프를 제거하고 ECMP를 이용하여 효율적인 트래픽 전송을 보장할 수 있음. | 데이터 센터 내 L2 및 L3 패브릭 기술을 통해 효율적인 통신 경로를 확보하고 병목 현상을 최소화할 수 있음. | VxLAN과 같은 오버레이 네트워크 기술을 이용해 가상화 환경에서도 동일 네트워크 구성과 안정적인 트래픽 전송을 가능하게 함. |

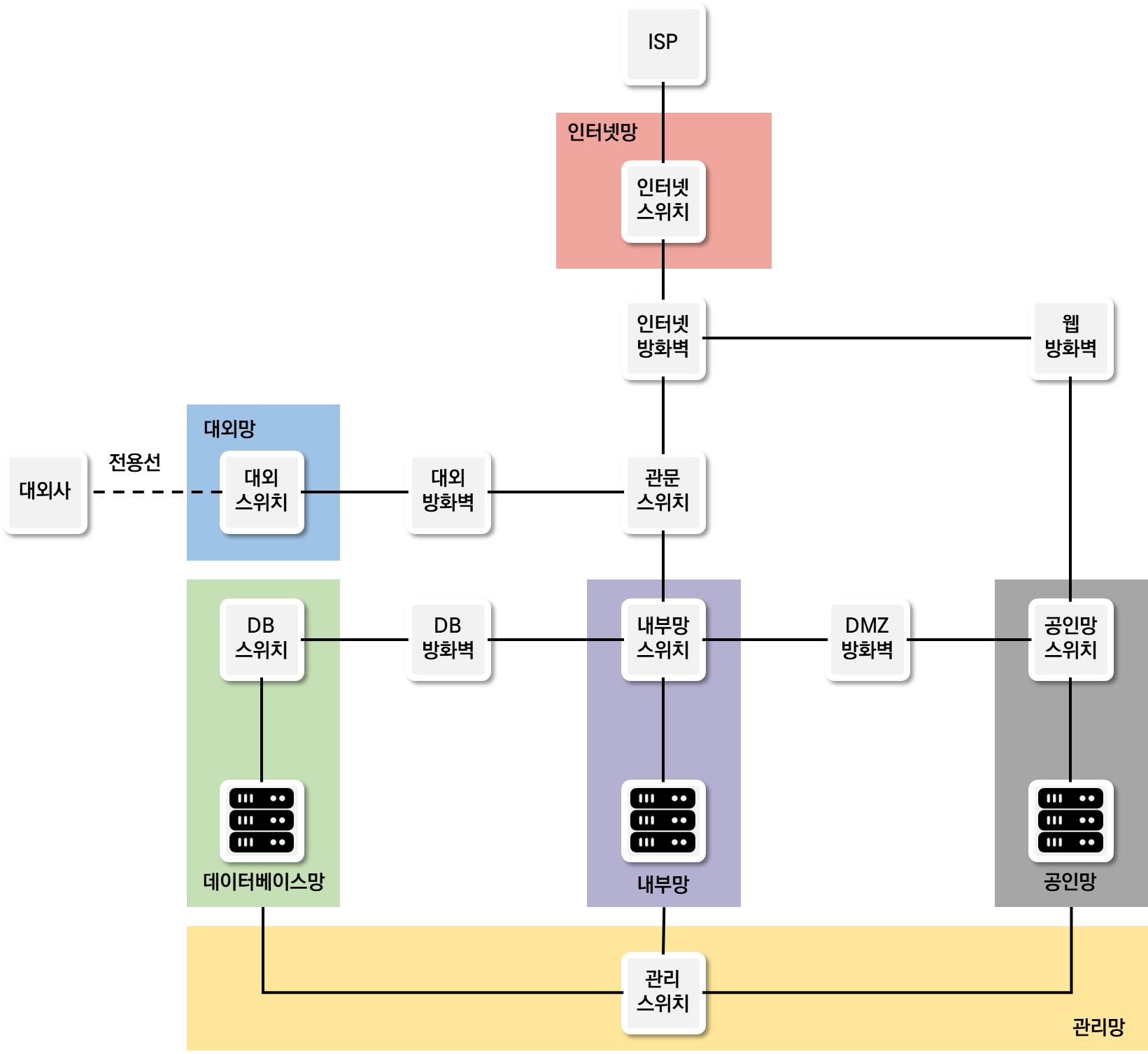

4. 데이터 센터 구성도: Zone/PoD 내부망/DMZ망/인터넷망

데이터 센터를 설계할 때는 보안, 관리, 성능 등을 고려하여 망을 분리하고 각 용도에 맞게 네트워크를 구성해야 한다. 분리된 망은 용도별로 나누어져 있어 망 간 보안을 고려해 방화벽과 같은 보안 장비와 연동하도록 구성해야 한다.

| 망 유형 | 설명 | 특징 및 용도 |

| 인터넷망 | 데이터 센터에서 외부 사용자들이 접근할 수 있도록 구성된 영역. ISP와 연결됨. | - KT, LG U+, SKB와 같은 ISP와 연동 - BGP 프로토콜과 AS 번호 사용 - 서비스 안정성을 위한 연결 이중화/삼중화 가능 |

| 공인망 (DMZ) |

데이터 센터 외부 사용자에게 직접 노출되는 서버들이 위치한 망. | - 외부 접근을 위한 공인 IP 사용 - 외부와 내부 네트워크의 경계 역할 - 보안을 위한 방화벽 연동 |

| 내부망 (사내망) |

데이터 센터 내부에서만 접근 가능한 네트워크. 일반적으로 사설 IP로 구성. | - 인터넷을 통한 외부 접근 불가 - 보안을 위해 외부망과 연결을 최소화 - NAT로 공인 IP 변환 필요 |

| 데이터베이스망 | 개인정보를 취급하는 데이터베이스를 위한 별도의 보안망. | - 데이터베이스 보안을 위해 방화벽 및 접근 통제 시스템 연동 - 내부망에서 추가 방화벽을 통해 보호 |

| 대외망 | 회사 간 서비스 연동을 위한 별도의 망. 전용선이나 VPN을 사용해 연결. | - 외부 회사와의 서비스 연동용 - 금융서비스 등 보안이 중요한 경우 전용선과 VPN 동시에 사용 |

| 관리망/OoB | 서버나 네트워크 장비 관리용 별도의 인터페이스 제공망. | - 서비스망과 분리된 관리망 - 장비 운용을 위한 CLI나 웹 접속 - 서비스망 문제 시 독립적으로 장비 접근 가능 |

| ※ 참고 : 서버의 관리용 포트 네트워크 장비에서는 관리용 포트를 보통 mgmt 인터페이스라고 부르지만 서버에서는 관리용 포트를 부르는 명칭이 벤더마다 다르다. - HP : ILO (Integrated Lights-Out) - DELL EMC : iDRAC (integrated Dell Remote Access Controller) - IBM : IMM (Integrated Management Module) - Cisco : CIMC (Cisco Integrated Management Controller) - Fujitsu : IRMC (Integrated Remote Management Controller) - Supermicor : iKVM (Integrated Keyboard, Video, and Mouse) 각 벤더의 서버 관리용 포트는 하드웨어 및 서버 상태 모니터링, 원격 관리 및 재부팅, 시스템 진단 등을 위한 기능을 제공하며, 이를 통해 관리자는 서버에 대한 물리적인 접근 없이도 서버를 원격으로 관리할 수 있다. |

5. 데이터 센터 네트워크 케이블링 구성

데이터 센터 내에서 서버, 스토리지, 네트워크 장비 등을 효율적으로 연결하기 위한 네트워크 케이블링 방식에는 ToR, EoR, MoR 등이 있으며, 이는 스위치의 물리적 위치에 따른 구성을 의미한다. 각 방식은 케이블 길이, 관리 용이성, 비용, 확장성 등에서 차이를 보인다.

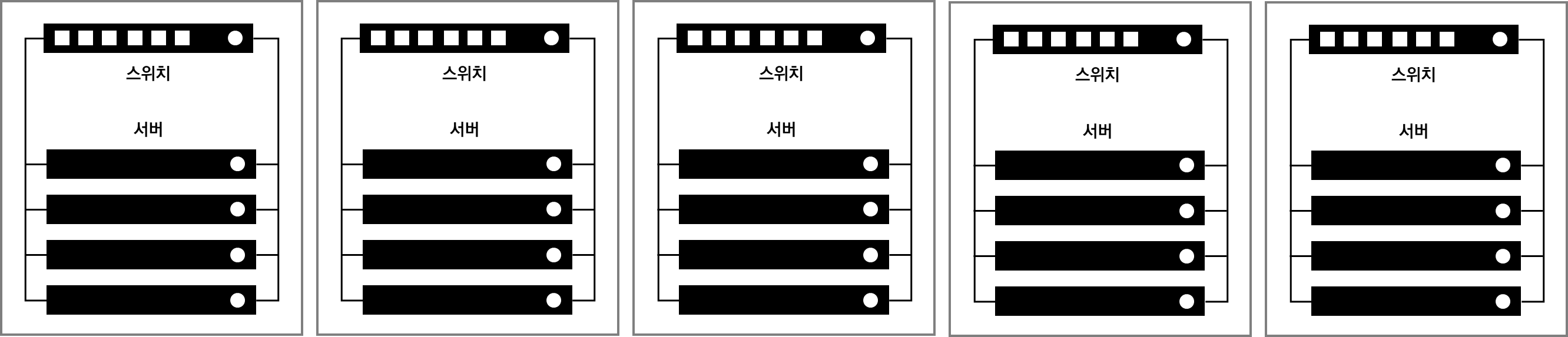

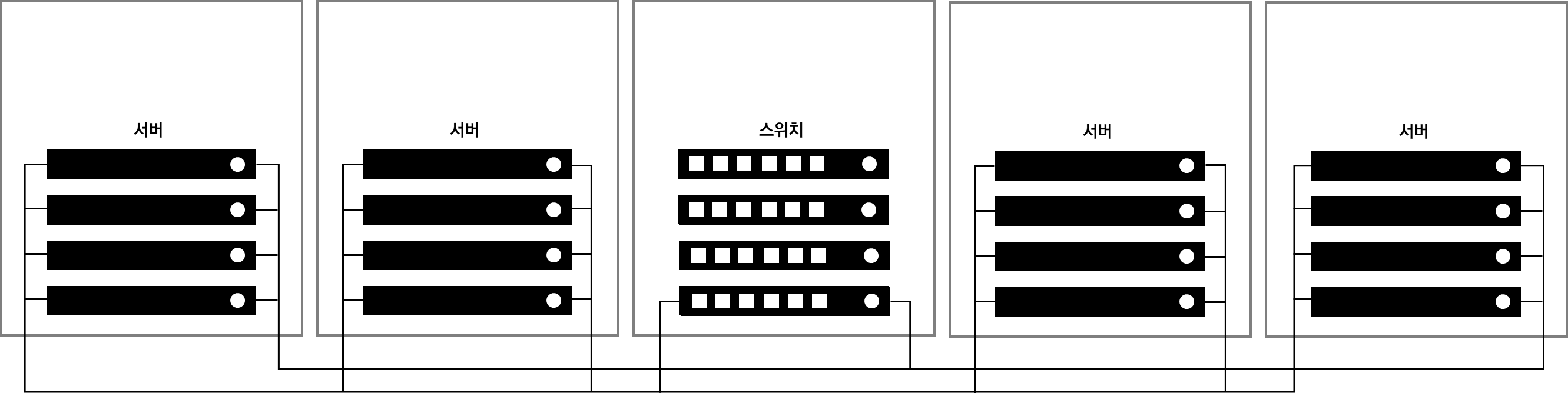

- ToR(Top of Rack)

ToR은 각 랙의 상단에 스위치를 설치하고 해당 랙에 있는 서버들을 연결하는 방식이다. 각 랙에 1개 이상의 스위치를 설치하고, 이를 통해 해당 랙의 서버와 네트워크 장비를 연결한다. ToR 방식은 랙 내에서 서버와 스위치가 가까워 케이블링이 짧고 간단해진다.

| 장점 | - 케이블 길이 단축: 서버와 스위치가 같은 랙에 배치되어 케이블이 짧고 관리가 용이함. - 물리적 네트워크 분리: 각 랙별로 네트워크 장비를 분리하여 독립적인 구성이 가능함. |

| 단점 | - 스위치 수 증가: 각 랙마다 스위치를 설치해야 하므로 네트워크 장비의 수가 많아짐. 이로 인해 관리 복잡도와 전력 소비가 증가함. - 운영 비용 증가: 스위치가 많아지면서 냉각 및 전력 비용이 증가하고, 미사용 포트가 많아져 포트 집적도가 떨어질 수 있음. |

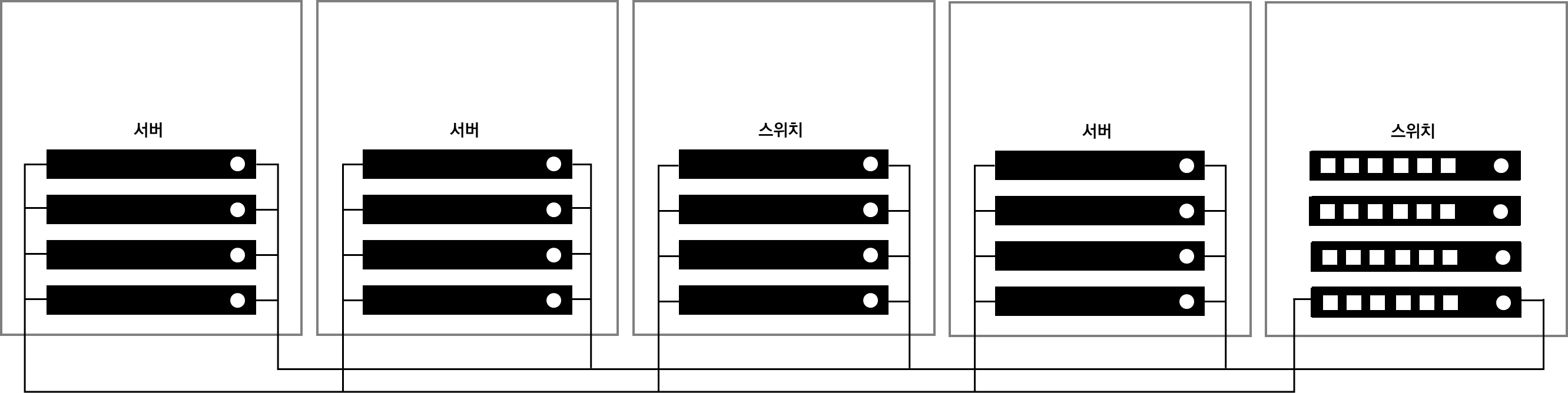

- EoR(End of Rack)

EoR은 각 랙에 설치된 서버들을 네트워크 장비가 위치한 랙까지 케이블로 연결하는 방식이다. 네트워크 장비는 데이터 센터의 행 끝에 위치하고, 서버는 이를 통해 연결된다.

| 장점 | - 스위치 수 감소: 개별 랙에 스위치를 설치하는 대신, 대형 섀시 스위치를 사용하여 라인 카드를 추가하는 방식으로 포트를 확장할 수 있음. 이를 통해 필요한 스위치 장비 수가 줄어듬. - 관리 용이성: 네트워크 장비가 중앙 집중화되어 관리가 용이하고, 네트워크 성능이 개선됨. - 대기 시간 감소: 스위치 수가 줄어들어 네트워크 지연이나 대기 시간이 줄어듬 |

| 단점 | - 케이블 길이 증가: 서버와 네트워크 장비 간의 거리가 멀어져 케이블 길이가 늘어나고, 복잡성이 증가함. - 업그레이드 비용 증가: 케이블 길이가 길어지면 향후 서버와 스위치 간 인터페이스 업그레이드 시 케이블 교체 비용이 증가할 수 있음. |

- MoR(Middle of Row)

MoR은 EoR과 유사하게 네트워크 장비를 별도의 랙에 배치하지만, 네트워크 장비가 데이터 센터의 행 끝이 아닌 중간에 배치되는 방식이다. 이로 인해 EoR보다 케이블 길이가 짧아지는 장점이 있다.

| 장점 | - 케이블 길이 단축: 네트워크 장비가 행의 중간에 배치되어 케이블 길이가 줄어들어 구축비용이 감소함. - 관리 효율성: EoR 방식의 이점을 유지하면서도 케이블 길이를 줄일 수 있음. |

| 단점 | - 복잡도 증가: 네트워크 장비가 중간에 위치하여 랙별 연결이 복잡해질 수 있음. 각 서버와 네트워크 장비 간의 연결 구조가 복잡해질 수 있음. |

ToR, EoR, MoR 방식은 각기 다른 장점과 단점을 가지고 있으며, 데이터 센터의 크기, 예산, 요구 사항에 따라 적합한 케이블링 방식을 선택해야 한다.

'네트워크 > 기술' 카테고리의 다른 글

| [보안] 보안의 개념과 정의 (3) | 2024.11.20 |

|---|---|

| [가상화 기술] 가상화 기술 (1) | 2024.11.19 |

| [안정성을 위한 기술] 로드 밸런서(3) (0) | 2024.11.18 |

| [안정성을 위한 기술] 로드 밸런서(2) (0) | 2024.11.17 |

| [안정성을 위한 기술] 로드 밸런서(1) (0) | 2024.11.16 |